爬虫质量的评价标准

从爬虫开发者的角度考虑一个好的跟踪器应该具备的几个特性。从搜索引擎用户体验的角度来看,爬虫的有效性有不同的评价标准,其中主要的三个标准是:被抓取网页的覆盖面、被抓取网页的新颖性和被抓取网页的重要性。网页抓取。如果这三件事都做对了,搜索引擎的用户体验应该是不错的。

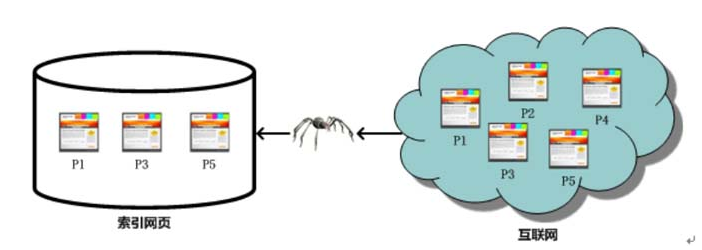

展示了一个抽象的互联网网页与搜索引擎爬虫抓取的网页的对比图。对于现有的搜索引擎,没有搜索引擎能够下载和索引出现在Internet 上的每个网页。所有的搜索引擎都只能索引互联网的一部分,所谓的抓取页面覆盖率是指爬虫抓取的页面数量占互联网所有页面数量的比例。如图所示,Internet 有5 页,跟踪系统跟踪其中的3 页。覆盖率越高,搜索引擎等效检索率越高,用户体验越好。

在爬虫爬取到的本地网页的情况下,可能有很多页面被更改、删除或内容被修改。因为一个爬虫爬完一个完整的回合需要很长时间,所以一定有一部分被爬过的页面。是过时的数据,即网页一变化就不能反映到网页库中。因此,网页库中的过时数据越少,网页的新颖性就越好,这对用户体验来说是显而易见的。如果更新不好,用户可能会发现过时的数据,甚至网页可能已经不存在,你可以想象他们在使用产品时的感受。

互联网上虽然有很多网页,但每个网页的重要性是非常不同的,例如,雅虎新闻网页和诱杀网页的重要性就大不相同。如果搜索引擎爬虫检索到的大部分网页都是主流网页,那么可以说他们已经很好地抓取了网页的重要性。这方面的良好工作等同于搜索引擎的高搜索精度。

综合考虑以上三个因素,目前爬虫的研发目标可以简单描述如下: 在资源有限的情况下,由于搜索引擎只能抓取互联网现有网站的一部分页面,选择最重要的部分尽可能多的页面。指数;对于已被爬取的网页,尽快更新您的内容,使被索引页面的内容与互联网上对应的页面同步更新;在此基础上,尽可能扩大抓取范围,以抓取更多以前无法发现的网页。这三个“尽可能”基本阐明了跟踪器系统改善用户体验的目的。