反作弊算法

过滤也是搜索引擎架构的重要组成部分。爬虫的爬取部分会过滤重复和垃圾页面,排序和提交时也会进行过滤,以保证搜索结果的质量。打击作弊是过滤过程的主要部分。当前搜索引擎排名的重要基准主要包括内容、链接、网站权重和用户体验,因此陷阱通常从这些方面开始。

虽然搜索引擎对每一种作弊都有不同的反作弊动作和算法,但总体上还是有一定的规则可以遵循的。搜索引擎将使用黑白名单和作弊功能研究来更新反作弊算法。

1.黑白名单

搜索引擎会根据网站内容的质量、权重和品牌将其列入白名单,还会找出哪些网站存在明显误导性和黑名单。搜索引擎会认为被列入白名单的网站推荐的网站是好的、健康的网站,而包含黑名单网站链接的网站可能存在一些问题。

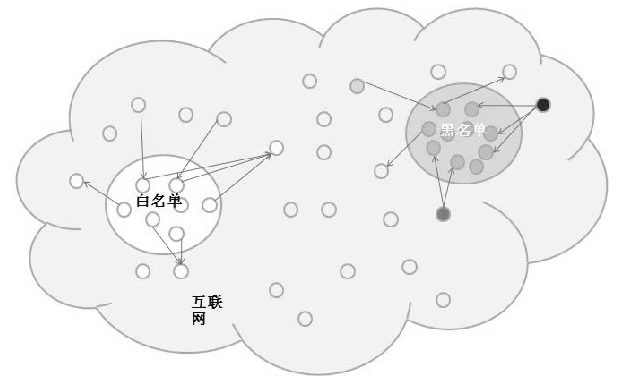

如如图2-24所示,白名单网站链接的网站不一定健康,黑名单网站链接的网站不一定不健康。但是,如果有多个列入白名单的网站链接到同一网站,则该网站很可能是健康的;如果同一个网站链接到多个列入黑名单的网站,则可以将其识别为不健康网站。

在整个互联网上,黑名单和白名单网站不可能与名单外网站有直接链接关系。因此,搜索引擎会给白名单中的链接一定的信任值。这个置信度值随着链接数的增加而增加。一步步衰败;同样,从黑名单网站的反面开始,对指向黑名单网站的各级链接都会赋予一个不信任值,并且这个值也会逐步降低。他通过了。对于不在黑白名单上且与黑白名单上的网站没有直接联系的网站,搜索引擎会计算其信任值和不信任值,当达到或超过设置的阈值时搜索引擎,它将被归类为健康网站或不健康网站。

这是一种非常常见的反作弊方法。 SEO工作中最明显的表现就是选择服务器和交换友情链接。在选择服务器的时候,大家都想独立使用一个服务器或者一个IP;在选择虚拟空间时,他们还会检查是否有相同IP的网站涉嫌作弊,以免受到相同IP网站的影响。虽然百度官方表示不会惩处IP类网站,但远离欺骗性网站还是比较安全的。这在交换友情链接时最为明显。一般会检查对方是否涉嫌作弊或降权,以免因将链接指向不良网站而被搜索引擎处罚。

2. 陷阱特性研究

作弊特征研究是目前打击搜索引擎作弊的主要方法。当发现对搜索结果有很大影响的作弊网站或新作弊技术时,通常不仅仅是为了降权或手动屏蔽这个或这些网站,而是研究这个网站或这些网站如何网站作弊,以及在搜索引擎技术和逻辑上钻了哪些漏洞。当发现漏洞时,算法会更新以弥补漏洞,同时针对这种作弊方式进行打击。谷歌近两年发布的算法更新都是定向的,不误导操纵公关的链接,也不误导影响用户体验的网站行为。对于百度来说尤其如此,自2012 年6 月更新其算法以来,百度一直专注于特定的作弊行为。这些都是在研究了作弊技术的特点后有针对性的算法更新。

因为是针对某个功能的反作弊算法的更新,所以也会出现这种情况:某个网站不作弊,但也有某些类似作弊网站的特征,被搜索引擎惩罚。特征的符合程度所受处罚的程度各不相同。也就是说